Innehåll

F:

Varför är konstgjorda återkommande nervnätverk ofta svåra att träna?

A:

Svårigheten att träna konstgjorda återkommande nervnätverk har att göra med deras komplexitet.

Ett av de enklaste sätten att förklara varför återkommande neurala nätverk är svåra att träna är att de inte är framtida neurala nätverk.

I feedforward neurala nätverk rör sig signaler bara ett sätt. Signalen flyttas från ett ingångsskikt till olika dolda lager och framåt till utgångsskiktet i ett system.

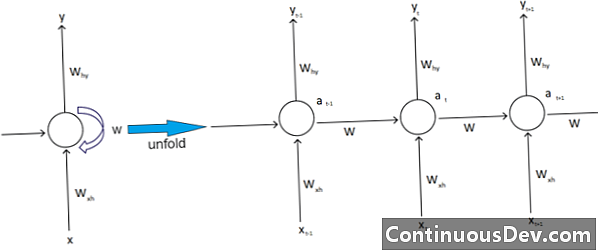

Däremot har återkommande neurala nätverk och andra olika typer av nervnätverk mer komplexa signalrörelser. Klassificerade som "feedback" -nätverk, återkommande neurala nätverk kan ha signaler som rör sig både framåt och bakåt och kan innehålla olika "loopar" i nätverket där nummer eller värden matas tillbaka till nätverket. Experter associerar detta med aspekten av återkommande neurala nätverk som är associerade med deras minne.

Dessutom finns det en annan typ av komplexitet som påverkar återkommande nervnätverk. Ett utmärkt exempel på detta är inom området naturligt språkbearbetning.

Vid sofistikerad naturligt språkbehandling måste det neurala nätverket kunna komma ihåg saker. Det måste ta input också. Anta att det finns ett program som vill analysera eller förutsäga ett ord i en mening med andra ord. Det kan till exempel finnas en fast längd på fem ord för systemet att utvärdera. Det betyder att det neurala nätverket måste ha ingångar för vart och ett av dessa ord, tillsammans med förmågan att "komma ihåg" eller träna på dessa ord. Av dessa och andra liknande skäl har återkommande neurala nätverk vanligtvis dessa små dolda slingor och återkopplingar i systemet.

Experter beklagar att dessa komplikationer gör det svårt att träna nätverken. Ett av de vanligaste sätten att förklara detta är genom att citera problemet med exploderande och försvinnande gradient. I huvudsak leder nätverkets vikter antingen till exploderande eller försvinnande värden med ett stort antal pass.

Neuronätverkets pionjär Geoff Hinton förklarar detta fenomen på nätet genom att säga att bakåt linjära passeringar kommer att göra att mindre vikter krymper exponentiellt och större vikter exploderar.

Detta problem, fortsätter han, blir värre med långa sekvenser och fler tidssteg, där signalerna växer eller förfaller. Viktinitialisering kan hjälpa, men dessa utmaningar är inbyggda i den återkommande nervnätverksmodellen. Det kommer alltid att vara den frågan kopplad till deras speciella design och byggnad. I huvudsak trotsar några av de mer komplexa typerna av neurala nätverk vår förmåga att enkelt hantera dem. Vi kan skapa en praktiskt taget oändlig mängd komplexitet, men vi ser ofta förutsägbarhets- och skalbarhetsutmaningar växa.