Innehåll

- Big Data är ostrukturerad eller halvstrukturerad

- Det finns ingen mening med att lagra Big Data om vi inte kan behandla dem

- Hur Hadoop löser Big Data-problemet

- Affärsfallet för Hadoop

Hämtmat:

Hadoop kan hjälpa till att lösa några av stora datas stora utmaningar.

Big data är ... ja ... stor i storlek! Exakt hur mycket data som kan klassificeras som big data är inte så tydligt klippt, så vi får inte fastna i debatten. För ett litet företag som är van vid att hantera data i gigabyte, skulle 10 TB data vara STOR. Men för företag som och Yahoo är petabytes stort.Bara storleken på big data gör det omöjligt (eller åtminstone kostnadseffektivt) att lagra dem i traditionell lagring som databaser eller konventionella filers. Vi pratar om kostnader för att lagra gigabyte data. Att använda traditionella lagringsfilrar kan kosta mycket pengar för att lagra big data.

Här kan du ta en titt på big data, dess utmaningar och hur Hadoop kan hjälpa till att lösa dem.Först upp, stora datas största utmaningar.

Big Data är ostrukturerad eller halvstrukturerad

Många big data är ostrukturerade. Till exempel kan klickströmloggdata se ut:tidsstämpel, user_id, sida, referrer_sida

Brist på struktur gör att relationsdatabaser inte passar bra för att lagra big data. Dessutom kan inte många databaser klara lagring av miljarder rader med data.

Det finns ingen mening med att lagra Big Data om vi inte kan behandla dem

Att lagra big data är en del av spelet. Vi måste bearbeta den för att mina intelligensen ur den. Traditionella lagringssystem är ganska "dumma" i den meningen att de bara lagrar bitar. De erbjuder inte någon processorkraft.Den traditionella databehandlingsmodellen har data lagrade i ett lagringskluster, som kopieras över till ett datorkluster för behandling. Resultaten skrivs tillbaka till lagringsklustret.

Denna modell fungerar dock inte riktigt för big data eftersom det kan vara för tidskrävande eller omöjligt att kopiera så mycket data till ett datorkluster. Så vad är svaret?

En lösning är att behandla big data på plats, till exempel i ett lagringskluster som fungerar som ett datorkluster.

Så som vi har sett ovan trotsar big data traditionell lagring. Så hur hanterar vi big data?

Hur Hadoop löser Big Data-problemet

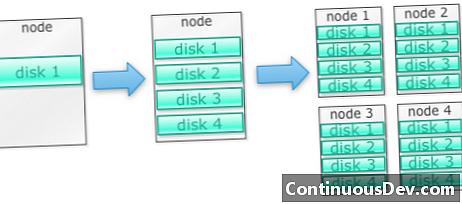

Hadoop är byggt för att köra på ett kluster av maskinerLåt oss börja med ett exempel. Låt oss säga att vi måste lagra massor av foton. Vi börjar med en enda disk. När vi överskrider en enda disk kan vi kanske använda några diskar staplade på en maskin. När vi maximerar ut alla diskar på en enda maskin, måste vi få en massa maskiner, var och en med ett gäng diskar.

Det är exakt hur Hadoop byggs. Hadoop är designad för att köras på ett kluster av maskiner från början.

Hadoop-kluster skalas horisontellt

Mer lagring och datorkraft kan uppnås genom att lägga till fler noder i ett Hadoop-kluster. Detta eliminerar behovet av att köpa mer och mer kraftfull och dyr maskinvara.

Hadoop kan hantera ostrukturerade / semistrukturerade data

Hadoop verkställer inte ett schema för de uppgifter som det lagrar. Den kan hantera godtyckliga och binära data. Så Hadoop kan enkelt smälta alla ostrukturerade data.

Hadoop-kluster erbjuder lagring och datoranpassning

Vi såg hur att separata lagrings- och bearbetningskluster inte passar bäst för big data. Hadoop-kluster tillhandahåller dock lagring och distribuerad dator allt i ett.

Affärsfallet för Hadoop

Hadoop tillhandahåller lagring för big data till rimlig kostnad

Att lagra big data med traditionell lagring kan vara dyrt. Hadoop är byggd kring varuhårdvara, så den kan ge ganska stor lagring till en rimlig kostnad. Hadoop har använts i fältet i petabyte skala.

En studie av Cloudera föreslog att företag brukar spendera cirka 25 000 till 50 000 dollar per terabyte per år. Med Hadoop sjunker denna kostnad till några tusen dollar per terabyte per år. När hårdvaran blir billigare och billigare fortsätter denna kostnad att sjunka.

Hadoop gör det möjligt att fånga in nya eller fler data

Ibland fångar organisationer inte in en typ av data eftersom det var för kostnadskrävande att lagra den. Eftersom Hadoop tillhandahåller lagring till rimlig kostnad kan denna typ av data fångas och lagras.

Ett exempel skulle vara klickloggar på webbplatsen. Eftersom volymen av dessa loggar kan vara mycket hög, fångade inte många organisationer dessa. Nu med Hadoop är det möjligt att fånga och lagra loggarna.

Med Hadoop kan du lagra data längre

För att hantera lagrad data rensar företag regelbundet ut äldre data. Till exempel kunde bara loggar under de senaste tre månaderna lagras, medan äldre loggar raderades. Med Hadoop är det möjligt att lagra den historiska informationen längre. Detta gör att ny analys kan göras på äldre historiska data.

Ta till exempel klickloggar från en webbplats. För några år sedan lagrades dessa loggar under en kort tid för att beräkna statistik som populära sidor. Nu med Hadoop är det möjligt att lagra dessa klickloggar under längre tid.

Hadoop tillhandahåller skalbar analys

Det finns ingen mening med att lagra all denna information om vi inte kan analysera dem. Hadoop tillhandahåller inte bara distribuerad lagring, utan också distribuerad bearbetning, vilket innebär att vi kan krossa en stor mängd data parallellt. Det berörda ramverket för Hadoop kallas MapReduce. MapReduce har visat sig vara storleken på petabytes.

Hadoop tillhandahåller rik analys

Native MapReduce stöder Java som ett primärt programmeringsspråk. Andra språk som Ruby, Python och R kan också användas.

Naturligtvis är att skriva anpassad MapReduce-kod inte det enda sättet att analysera data i Hadoop. Kortminskning på högre nivå är tillgänglig. Till exempel tar ett verktyg som heter Pig engelska som dataflödesspråk och översätter dem till MapReduce. Ett annat verktyg, Hive, tar SQL-frågor och kör dem med MapReduce.

Business intelligence-verktyg (BI) kan ge ännu högre analysnivå. Det finns verktyg för denna typ av analys också.

Detta innehåll är utdraget från "Hadoop Illuminated" av Mark Kerzner och Sujee Maniyam. Det har gjorts tillgängligt via Creative Commons Attribution-NonCommercial-ShareAlike 3.0 Unported-licens.